随着计算视觉和数字图像处理技术的不断发展以及计算机美学的不断进步, 图像美感品质评价研究越来越受到人们的重视, 在图像检索、图像编辑中起到越来越重要的作用。传统的图像美感品质评价主要将图像分为高美感品质和低美感品质两种。针对影响图像美感的一些客观因素, 人们使用计算机提取大量局部或者全局、高维或低维特征, 然后进行学习和分类, 模拟人脑对图像进行美感品质的评价。文献[1]一共提取了56种构图、颜色、亮度等特征, 使用线性回归的方法来量化美感度的评分。文献[2]共提出了3类局部特征和2类全局特征用于图像的品质评价, 使用受试者工作特征曲线(receiver operating characteristic curve, ROC)对这些特征的性能进行评价。文献[3]也是将图像的特征分为了局部和全局两类, 在局部特征中采用了Gabor小波变换及class imbalance和total scene understanding两种不同的方法对不同内容的图像提取其主体部分, 以及在全局特征中采用了色调直方图和颜色派量化照片美感品质。文献[4]对描述图像的美感品质和兴趣性的三分构图法等高阶属性进行了研究。该项研究主要提出对于美感质量的三类属性:结构属性、内容属性和亮度属性, 以及如何去预测图像“兴趣性”的方法。文献[5]将研究的重点置于图像的结构特征对其美感品质的影响上, 使用了55个与结构信息相关的特征, 分类准确率十分逼近美学基准准确率。文献[6]、[7]使用41种构图、颜色、亮度等全局和局部特征对图像进行美感品质的分类, 通过试验, 这41种特征在对图像进行美感品质评价和分类时均有较好的准确率。但是这些通过人工提取的特征有限, 并不能完全满足图像美感品质评价的需求。

随着深度学习逐渐成为人工智能、机器学习的主流方向, 在各大研究领域都取得了突出的表现。文献[8]最早将卷积神经网络用于手写体数字的识别。2006年, 文献[9]重新开启深度学习在学术界和工业界的浪潮。在2012年ImageNet的图像分类竞赛中, 文献[10]的Alexnet模型以错误率为15.3获得了冠军。在图像美感品质评价研究中, 文献[11]使用并行卷积神经网络结构对图像进行美感品质评价, 在Photo Quality数据库中取得了优于传统提取人工设计特征方法的识别率。文献[12]使用并行网络结构, 引入了风格和语义属性, 同时提出了内容自适应的训练方法, 在AVA(a large-scale database for aesthetic visual analysis)数据库上进行试验, 得到的识别准确率比传统方法要高出10%左右。但是深度学习是大数据时代下的产物, 往往需要大量的数据做支持。目前用于图像美感品质评价的数据库都较小, 在训练卷积神经网络模型时无法保证获得足够的学习样本从而导致训练出的卷积神经网络模型的识别准确率不理想。深度卷积神经网络fine-tune训练方法是一种解决小数据库训练的方法, 在很多视觉领域的研究中, 如视频追踪[13]、目标检测[14]、人脸识别[15]、图像风格分类[16]等研究中广泛使用。在训练方法中fine-tune基于一个预训练好的模型, 采用相同的网络结构, 使用不同于预训练好模型的数据, 根据所要完成任务的要求, 调整输出, 在预训练好的模型参数上进行再训练, 体现了一种迁移学习的方式。本研究主要使用fine-tune方法对图像数据库进行训练。

本研究的主要工作有:(1)分析了不同卷积神经网络结构和图像内容对图像美感品质的影响, 针对图像美感品质数据库较小的问题, 使用卷积神经网络fine-tune方法, 基于不同网络结构在ImageNet上训练得到的模型进行再训练, 提升图像美感品质识别效果; (2)在按图像内容进行美感品质评价研究时, 针对图像数据再次减小的问题, 提出了连续使用两次fine-tune的嵌套fine-tune方法, 试验结果表明, 嵌套fine-tune方法很好的解决了图像美感品质数据库较小的问题, 进一步提升图像美感品质的识别效果。

1 图像美感品质评价方法本研究选取Photo Quality Database作为图像来源。Photo Quality是文献[2]从图像分享网站或从自己拍摄的图像中选取出来做成的一个有图像品质分类的图片库。在这个库中共有17 613张均经过十位观察者进行了高或低品质分类的图像, 而且对每张图像的分类结果至少有八位观察者做出了相同的判断才最终记录为该张图像的主观品质评价, 如图 1所示(第一行为高美感品质图像, 第二行为低美感品质图像)。这个库中的图像又被分为动物、植物、静物、建筑、风景、人物、夜景7个大类。如表 1所示, 本研究对数据库中的图像再次进行筛选, 选取其中的15 562图像作为本研究试验数据。

|

图 1 不同美感品质的图像 Figure 1 Images with different aesthetic quality |

| 表 1 Photo Quality数据库中各类图像的数量 Table 1 The number of all kinds of images in Photo Quality database |

本研究采用Alexnet和VGG_S两种卷积神经网络对图像进行美感品质评价。如表 2所示, Alexnet是一个由五个卷积层以及三个全连接层组成的卷积神经网络。卷积层的滤波器使用均值为1, 方差为0的高斯函数进行初始化。Alexnet将输入图像分为R、G、B三个维度, 把图像初始化为256×256大小, 然后对图像进行四个边角和中间的剪裁, 剪裁成大小为227×227, 然后再对剪裁好的图像进行镜像处理, 扩充数据的数量。为了防止产生过拟合, 在Alexnet中采用了很多算法来降低过拟合现象。如ReLU是线性整流层, 可以进行良好的梯度传递, LRN是局部响应归一化, 增强局部响应, 在全连接层加入dropout算法, 减小过拟合。VGG_S是文献[17]对Alexnet网络做的一些细小变化, 但是VGG_S在ImageNet图像识别中错误率为13.1, 低于Alexnet的15.3。VGG_S同样是一个五个卷积层和三个全连接层组成, 但是VGG_S将输入图像大小初始化为256×256后剪裁为224×224, 同时减小了初始卷积层的滤波器大小和移动步幅。

| 表 2 Alexnet和VGG_S的网络结构及参数设置 Table 2 Architecture and parameter setting of Alexnet and VGG_S |

在使用fine-tune训练方法时, 将两个网络结构的最后一层Fc8滤波器学习率参数初始化为10, 偏置学习率为20, 并将原输出参数1 000改为2(高美感品质和低美感品质两类)。整个网络的初始动量为0.9, 权重衰减为0.000 5, 初始学习率为0.000 1。

1.2 Alexnet和VGG_S对图像进行美感品质研究为了验证Alexnet和VGG_S哪种网络结构更加适合图像美感品质评价任务, 本研究将Photo Quality中所有的图像分为高美感品质和低美感品质两个部分, 使用fine-tune方法基于Alexnet和VGG_S得到的模型Alexnet_Model和VGG_S_Model进行再训练得到Alexnet_FT_All和VGG_S_FT_All。为了便于与后面试验结果的比较, 本研究分别测试了不同内容图像的识别准确率。

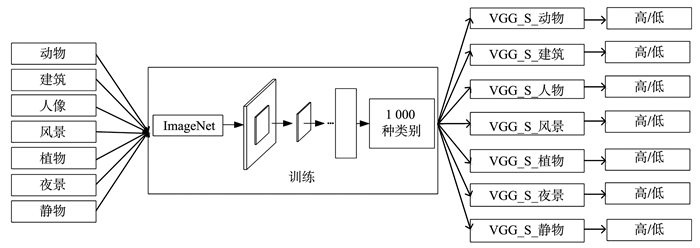

1.3 基于图像内容对图像进行美感品质评价在对图像美感进行研究时发现, 不同内容的图像在拍摄时会有不同的拍摄方法。为考察图像内容对美感品质评价的影响, 本研究将Photo Quality中的每一种内容的图像划分为高美感品质和低美感品质, 基于VGG_S_Model在每种内容训练一个用于美感品质评价的模型。如图 2所示, 在中间方框中, VGG_S_Model是VGG_S在ImageNet上训练得到模型, 然后对七种内容的图像训练了七个不同的用于图像美感品质评价的模型:VGG_S_动物, VGG_S_建筑, VGG_S_人物, VGG_S_风景, VGG_S_夜景, VGG_S_植物, VGG_S_静物, 在测试时, 进行分开测试, 将动物、建筑、人物、风景、夜景、植物和静物的测试数据分别用其对应的模型进行测试, 得出七个模型的识别准确率。

|

图 2 基于图像内容对图像进行美感品质研究 Figure 2 Image aesthetic quality research based on image contents |

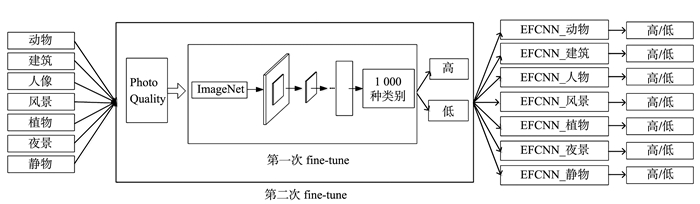

在基于图像内容对图像进行美感品质评价时, 由于将图像按内容划分后, 用于训练的图像数量减少, 为了弥补训练图像数量减少带来的影响, 本研究提出了一种嵌套fine-tune方法, 连续使用两次fine-tune进行网络训练, 如图 3所示, 将Photo Quality中每一类的图像分为高美感品质和低美感品质, 使用fine-tune方法基于VGG_S_FT_ALL训练七个用于各个内容图像美感品质评价的模型EFCNN_动物, EFCNN_建筑, EFCNN_人物, EFCNN_风景, EFCNN_夜景, EFCNN_植物, EFCNN_静物, 其中EFCNN(embedded fine-tune convolution neural network, EFCNN)表示嵌套fine-tune卷积神经网络。

|

图 3 使用嵌套fine-tune方法对图像进行美感品质研究 Figure 3 Image aesthetic quality research by Embedded fine-tune |

试验在数据库Photo Quality上进行, 采用Caffe[18]作为本研究的试验平台, 试验所用到的显卡为GTX1 070, 显存8 GB。

2.1 Alexnet和VGG_S对图像美感品质评价的效果分析由于Photo Quality中高美感品质的图像数量较少, 而低美感品质的图像数量较多, 所以本研究从高美感品质图像中选取了大约700张, 低美感品质图像中选取大约2 100张作为本研究的测试样本, 剩下的作为训练样本。本研究将所有的数据按照文献[10]的扩充方法将训练样本进行扩充。

本研究基于Alexnet_Model和VGG_S_Model训练了四个用于图像美感品质模型, 分别是:Alexnet_FT_All、VGG_S_FT_All, 以及新增加的两个模型Alexnet_Non_All和VGG_S_Non_All, 其中Alexnet_Non_All和VGG_S_Non_All是使用Alexnet和VGG_S网络结构但是没有使用fine-tune方法得到的模型。Alexnet_FT_All和VGG_S_FT_All是使用Alexnet和VGG_S网络结构并且使用fine-tune方法得到的模型。如表 3所示, 从四个模型的对比试验结果来看, Alexnet_FT_All, VGG_S_FT_All试验效果要好于Alexnet_Non_All和VGG_S_Non_All, 表格中的加粗数据代表最高正确率。这说明fine-tune方法在美感品质试验中同样适用。本研究再通过对比Alexnet_FT_All与VGG_S_FT_All的试验结果, VGG_S_FT_ALL在每种内容图像的美感品质识别准确率比Alexnet_FT_All得到的结果都有一定的提升, 平均高出0.87%, 说明VGG_S网络结构比Alexnet网络结构更适合本研究这次的图像美感品质评价任务。

| 表 3 使用Alexnet和VGG_S对图像美感品质评价的正确率 Table 3 Accuracy of image aesthetic quality evaluation by Alexnet and VGG_S |

根据2.1所得到的结果, 本研究试验使用fine-tune方法和VGG_S网络结构对Photo Quality中的图像分内容进行美感品质评价。同样从每个内容的高美感品质中随机抽取大约100张图像, 低美感品质中随机抽取大约300张图像作为测试数据, 其余的图像作为训练数据, 使用文献[17]的数据扩充方法, 按图 2进行训练, 得到了7个模型VGG_S_FT_i, i代表了动物、建筑、人物、风景、夜景、植物、静物。

为了验证内容对图像进行美感品质评价的有效性, 本研究将2.1的试验结果同本次试验结果进行比较, 如表 4所示, 从试验结果可以看出VGG_S_FT_i在每一种内容中的识别效果均要好于VGG_S_FT_ALL, 表格中的加粗数据代表最高正确率, 这说明按内容训练的神经网络针对性更强, 能保障与之对应内容的图像美感品质评价效果。

| 表 4 基于图像内容对图像进行美感品质评价的正确率 Table 4 Accuracy of image aesthetic quality evaluation based on image contents |

在使用嵌套fine-tune方法时, 本研究同样从每种内容的高美感品质中随机抽取大约100张图像, 低美感品质中随机抽取大约300张图像作为测试数据, 其余的图像作为训练数据, 为了保证在使用嵌套fine-tune时, 数据不重叠, 此次试验中的训练数据和测试数据均是2.1训练数据和测试数据的一个子集。

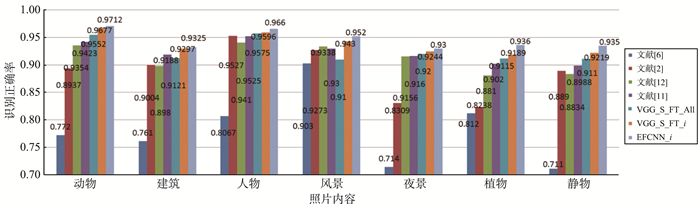

同传统方法进行对比时, 本研究主要与文献[2]在基于图像内容对图像进行美感品质评价中的方法以及文献[6]、[7]在景物图像美感品质评价中用到的方法进行比较。在与现存深度学习方法进行比较时, 本研究主要与文献[12]的DCNN和文献[11]的PDCNN的方法进行比较。试验结果如表 5所示, 图 4是试验结果的可视化表示。

| 表 5 本文算法与其他图像美感品质评价算法正确率的比较 Table 5 Accuracy of aesthetic quality evaluation for different methods |

|

图 4 本文算法与其他图像美感品质评价算法正确率的比较 Figure 4 Accuracy of aesthetic quality evaluation for different methods |

如表 5和图 4所示, 文献[2]是Photo Quality中使用传统提取人工设计特征方法中最好的方法, 但本研究提出的EFCNN_i比文献[2]提出的方法的评价正确率平均高出5.36%, 其中在植物内容中EFCNN_植物比文献[2]提出的方法的评价正确率高出11.22%。与文献[6]、[7]进行比较, EFCNN_i的评价正确率平均高出16.31%, 其中EFCNN_静物的评价正确率高出22.4%。

文献[11]、[12]提出了两种使用深度学习对图像进行美感品质评价的方法。EFCNN要比文献[11]提出的方法的评价正确率平均高2.33%, 其中在静物内容图像中, EFCNN_静物比文献[11]的方法的评价正确率高出3.62%。在同文献[12]方法进行比较时, EFCNN_i的评价正确率平均高出3.35%, 其中在植物内容图像中, EFCNN_植物的评价正确率高出5.5%。

相较于VGG_S_FT_i, EFCNN_i在各种内容的图像美感识别率均有提高, 平均高出0.88%, 其中EFCNN_植物比VGG_S_FT_植物高出1.71%。虽然EFCNN_i的评价正确率比VGG_S_FT_i高出仅有0.88%, 但是VGG_S_FT_i在各种内容图像美感品质评价得到的识别率, 在数据很小的情况下已经非常高, 尤其是在VGG_S_FT_动物VGG_S_FT_风景达到了95%以上的识别率, 而使用嵌套fine-tune的方法能够在已经很高的识别率上能够再有所提升, 说明嵌套fine-tune能够很好地解决在分内容对图像进行美感品质研究时, 数据减小的问题, 同时这种嵌套fine-tune方法, 将本已很小的数据库中的资源进行充分地利用, 调动整个数据库的数据来提升图像美感品质识别效果。

3 结语本研究主要在基于图像的内容对图像进行美感品质评价时, 为了解决分内容后数据减小的问题和使用一次fine-tune不能充分利用数据库的问题, 提出了一种渐进式的fine-tune方法, 嵌套fine-tune方法。同时在对图像进行美感品质研究时, 分析了图像内容对图像美感品质识别效果的影响。本研究在小数据库Photo Quality中进行试验, 通过试验结果得知, 基于图像内容使用嵌套fine-tune方法, 不仅充分利用数据库中的数据, 而且解决了分内容对图像进行美感品质评价时, 数据减小的问题, 提升了图像美感品质的识别准确率。

| [1] | DATTA R, JOSHI D, LI J, et al. Studying aesthetics in photographic images using a computational approach[C]//European Conference on Computer Vision. Graz, Austria: Springer-Verlag, 2006: 288-301. https://link.springer.com/chapter/10.1007%2F11744078_23 |

| [2] | LUO W, WANG X G, TANG X OU. Content-based photo quality assessment[J]. IEEE Transaction on Multimedia, 2013, 15(8): 1930-1943 DOI:10.1109/TMM.2013.2269899 |

| [3] | SHAO J, ZHOU Y. Photo quality assessment in different categories[J]. Journal of Computational Information Systems, 2013, 9(8): 3209-3217 |

| [4] | DHAR S, ORDONEZ V, BERG T L. High level describable attributes for predicting aesthetics and interestingness[C]// Computer Vision and Pattern Recognition. Colorado, USA: IEEE Computer Society, 2011: 1657-1664. https://ieeexplore.ieee.org/document/5995467/ |

| [5] | OBRADOR P, SCHMIDT-HACKENBERG L, OLIVER N. The role of image composition in image aesthetics[C]//IEEE International Conference on Image Processing. Hong Kong, China: IEEE Xplore, 2010: 3185-3188. https://ieeexplore.ieee.org/abstract/document/5654231/ |

| [6] | WANG C H, PU Y Y, XU D, et al. Evaluating aesthetics quality in scenery photo[C]//Proceeding of National Conference on Multimedia Technology. Beijing, China: Machinery Industry Press, 2015: 141-149. |

| [7] | WANG C, PU Y, XU D. Evaluating aesthetics qualities in portrait images[J]. Journal of Software, 2015, 26(S2): 20-28 |

| [8] | LECUN Y, BOSER B, DENKER J, et al. Back propagation applied to handwritten zip code recognition[J]. Neural Computation, 2014, 1(4): 541-551 |

| [9] | HINTON G E, OSINDERO S, TEH Y W. A fast learning algorithm for deep belief nets[J]. Neural Computation, 2006, 18(7): 1527-1544 DOI:10.1162/neco.2006.18.7.1527 |

| [10] | KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks[C]//International Conference on Neural Information Processing Systems. Nevada, USA: Curran Associates Inc, 2012: 1097-1105. https://link.springer.com/chapter/10.1007%2F978-3-319-41501-7_3 |

| [11] | GUO L, LI F, LIEW W C. Image Aesthetic Evaluation Using Parallel Deep Convolution Neural Network[C]//International Conference on Digital Image Computing: Techniques and Applications. Gold Coast, Australia: IEEE Computer Society, 2016: 1-5. |

| [12] | LU X, LIN Z, JIN H, et al. Rapid: rating pictorial aesthetics using deep learning[C]//Proceedings of the ACM International Conference on Multimedia. Orlando, USA: ACM, 2014: 457-466. |

| [13] | WANG L, OUYANG W, WANG X, et al. Visual tracking with fully convolutional networks[C]//IEEE International Conference on Computer Vision. Santiago, Chile: IEEE Computer Society, 2015: 3119-3127. http://scott89.github.io/FCNT/ |

| [14] | GIRSHICK R, DONAHUE J, DARRELL T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]//IEEE Conference on Computer Vision and Pattern Recognition. Columbus, USA: IEEE Computer Society, 2014: 580-587. |

| [15] | SUN Y, WANG X, TANG X. Deep learning face representation from predicting 10 000 classes[C]//IEEE Conference on Computer Vision and Pattern Recognition. Hong Kong, China: IEEE, 2014: 1891-1898. |

| [16] | KARAYEV S, TRENTACOSTE M, HAN H, et al. Recognizing image style[EB/OL]. (2014-7-23)[2018-3-22]. https://arxiv.org/abs/1311.3715. |

| [17] | CHATFIELD K, SIMONYAN K, VEDALDI A, et al. Return of the devil in the details: delving deep into convolutional nets[C]//Proceeding of British Machine Vision Conference. Nottingham, UK: BMVA Press, 2014. http://www.oalib.com/paper/4045769#.WznvJvmfAiQ |

| [18] | JIA Y, SHELHAMER E, DONAHUE J, et al. Caffe: convolutional architecture for fast feature embedding[EB/OL]. (2014-6-20)[2018-3-22]. https://arxiv.org/abs/1408.5093 |