2. 广东外语外贸大学信息科学与技术学院, 广东 广州 510006;

3. 广东外语外贸大学国际学院, 广东 广州 510420

2. School of Information Science and Technology, Guangdong University of Foreign Studies, Guangzhou 510006, Guangdong, China;

3. International College, Guangdong University of Foreign Studies, Guangzhou 510420, Guangdong, China

随着Web技术的发展, 互联网逐渐倡导“以用户为中心, 用户参与”的开放式构架理念, 产生了大量的用户参与, 形成了海量的产品评论数据。对海量产品评论文本情感挖掘, 有利于产品推荐、观点抽取和口碑预警等研究。词语是组成评论文本的语义单元, 表达了用户的观点和情感。以词汇为情感单元, 构建情感词典, 可简单、快速地应用到海量文本情感分析[1]。但面向酒店、电子产品、日常用品等领域产品评论, 用户使用的评价词具有较大的差异, 对文本情感分析提出了新的挑战。因此, 有必要构建领域情感词典, 以适应该领域的文本情感分析研究。在情感词典中, 情感词的情感特征可用情感倾向和权重来表示。国外知名的情感词典SentiwordNet[2]将词汇映射到正向(P)、中性(ne)和负向(N)三个极性, 并赋予权重, 则每一个情感词可用[P ne N]三维情感特征来表示。国内权威的知识库HowNet[3]则将正向情感词映射到[1 0], 负向情感词映射到[0 -1]的二维特征向量。

针对情感特征的提取, 国内外学者提出了多种研究方法, 如利用SentiwordNet和HowNet等情感词典的方法[4-9]、基于种子词和互信息的方法[10-12]、基于机器学习的方法[11-15]等。文献[4]利用情感词典作为情感特征提取的基础, 实现了文本情感分析。文献[5]针对同一词汇在不同情感词典中的极性不同, 提出一种自动的领域情感极性特征映射方法。文献[6]基于神经网络和情感词典, 对短文本进行情感特征提取。朱嫣岚等[7]提出了基于语义相似度和语义相关场的两种词汇语义倾向性计算方法, 通过计算目标词汇与HowNet中己标注褒贬性词汇间的相似度得到目标词汇的倾向性。文献[8]在HowNet情感词语集的基础上, 利用其提供的义原计算两个词的相似度, 根据词与正向和负向种子词的平均相似度的差, 提取词语的情感倾向。文献[9]基于HowNet和SentiWordNet将词语自动分解为多个义原后计算其情感倾向强度。利用SO-PMI方法, 选择具有情感代表性的种子词集, 在已标注语料或基于搜索引擎, 计算词语在正向和负向上的情感权重, 可将情感词语有效映射到情感特征向量[P N][10-12]。

利用机器学习方法, 通过对语料的统计和计算, 也可实现情感特征的提取。如彭丽针和吴扬扬[13]提出将单词之间的语义特征映射到页面、页面社区和页面社区所属类别上。文献[14]根据评论和新闻的对比分析获得候选情感特征, 然后经过相关的扩充和验证操作得到通用的情感特征。文献[15]在评论中提取普通分类特征和情感特征, 普通分类特征可以用来训练一个情感分类器。然后使用spectral聚类算法把这些情感特征映射成扩展特征。文献[16]结合TF-IDF方法与方差统计方法, 提出一种实现多分类特征抽取的计算方法。采用先极性判断后细粒度情感判断的处理方法, 构建细粒度情感特征提取过程。文献[17]基于词语情感权重与文本情感倾向的相关假设, 结合二元分类的特性改进了信息增益(information gain, IG)和卡方统计量(chi-square, CHI), 将特征选择技术应用于情感词权重特征的计算。Alaa Hamouda等[18]基于机器学习方法, 构建了机器学习型情感词典(machine learning based senti-word lexicon, MLBSL), 取得了较SentiWordNet更高的微平均值。

现有的情感特征提取方法, 更注重于将词语的情感映射到二维或三维特征向量, 也有研究人员尝试对情感特征进行拓展[13-17]。低维的情感特征向量虽然表示简单, 使用方便, 但只表达了情感强度, 缺乏语义表示, 不能对词语的情感相关性进行表示。如“干净”“清洁”和“安静”在酒店评论中多数表达正向评价, 如果用一个数值来简单表示, 情感倾向和强度均相近, 但并不能表达“干净”与“清洁”情感更相关。随着对深度学习研究的发展, 对词汇语义和情感的抽象表示也有了新的思路与方法[19-21]。如Mnih & Kavukcuoglu[19]利用噪声估计对比(noise-contrastive estimation)方法, 获得更简单、快速和更优效果的词向量表示。Camacho-Collados和Navigli[20]提出QVEC-CCA模型, 主要基于人工标注的语言资源, 构建具有语言特性的矩阵。在词语类别分类相似性的任务上(如fish属于NN.ANIMAL), 表现出较好的效果。文献[21]提出了一种词向量表示的评价框架, 通过孤立点检测任务进行验证, 试验结果表示与人工标注的结果对比, 仍然存在较大的改进空间。这些研究都为词语情感特征向量表示研究提供了新的方法。Google在2013年利用深度学习的思想, 通过训练大量文本, 将词语映射到k维向量空间中进行向量运算, 而向量空间上的相似度可以用来表示词语在语义上的相关度, 为情感特征表示研究提供了新思路。因此, 本研究利用word2vec, 对大量语料进行学习, 选择情感种子词作为基准, 利用word2vec的语义计算优势, 将情感特征进行高维映射, 并试验验证情感特征在语义表示和情感表示上的有效性。

1 基于词向量的领域情感词典构建方法 1.1 词向量模型本研究通过在大量数据中训练神经网络来获得词向量(distributed representation), 基本思想是通过训练将每个词映射成k维实数向量, 通过设置上下文的深度, 可获得文本数据更加深层次的特征表示。这种词语的表示方式优于传统的One-hot Representation, k维向量不但包含了词语间的潜在语义关系, 同时也避免了维数灾难。

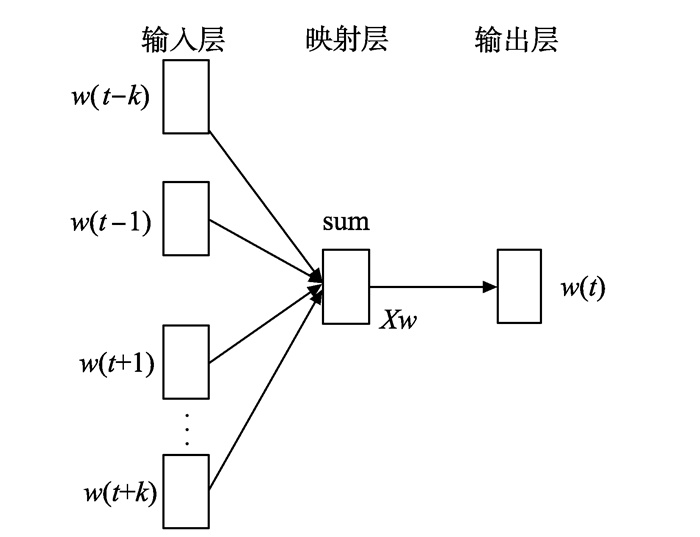

本研究利用Google开源工具, 在Python平台上, 选用了CBOW模型, 如图 1所示, CBOW模型的原理与神经网络概率语言模型(neural netword language model, NNLM)类似, 都是利用当前词wt的上下文wt-k, …, wt-1, wt+1, …, wt+k预测当前词wt的概率P(wt|wt-k, …, wt-1, wt+1, …, wt+k)。与NNLM不同的是, CBOW模型去掉了最耗时的非线性隐藏层, 并让输入层的所有词语共享映射层。如图 1中CBOW模型使用单词wt周边的词语作为输入, 在映射层做加权处理, 然后输出单词wt。

|

图 1 CBOW模型的框架 Figure 1 Framework of CBOW model |

word2vec考虑了当前词的上下文信息, 由此学习到的词向量包含了丰富的语义和语法关系。本研究的训练语料集为sogou全网新闻数据(sogouCA), 随机取其中25万篇新闻, 涉及到国内、国际、体育等18个频道的新闻数据。采集酒店评论语料共10万余条评论文本。将sogou新闻语料和酒店评论语料共35万余篇作为word2vec的训练数据集Data_w2v。训练模型选用CBOW, 得到模型M_w2v。

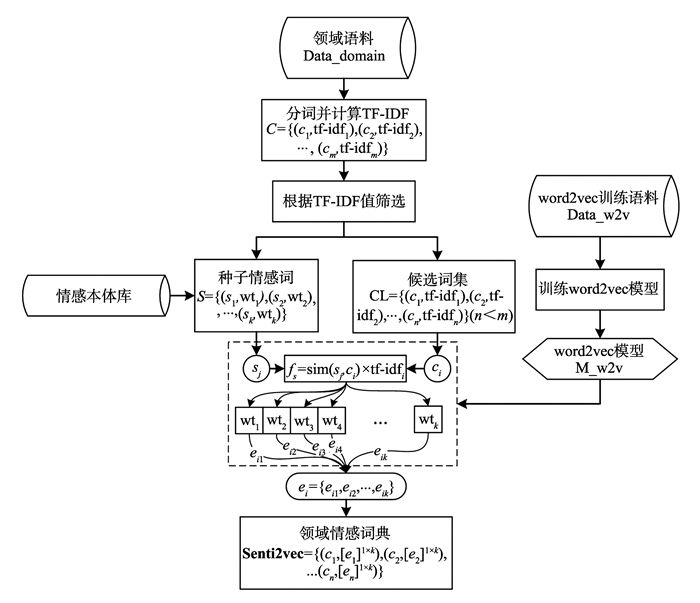

1.2 领域情感词典构建方法领域情感词典是领域情感分类的重要工具。针对特定领域语料, 如酒店评论、电影评论等领域语料中, 面向的评价对象不同(如酒店评论中的环境、卫生、服务等, 电影评论中的演技、画面、剧情等), 评价用语往往也不相同。利用这一特点, 通过领域语料中的词汇分布特点, 结合相关算法, 可计算得到更能表达该领域情感特征的情感词及其情感向量。鉴于此, 本研究采用如图 2所示的领域情感词典构建算法。首先, 对领域产品评论语料进行分词, 并计算词汇的TF-IDF值, 获得词集C={(c1, tf-idf1), (c2, tf-idf2), …, (cm, tf-idfm)}。根据TF-IDF值的排序, 借鉴文献[9]对种子词汇的选择规则, 在词集C中获得种子词集S={(s1, wt1), (s2, wt2), …, (sk, wtk)}, 其中sj(j=1, 2, …, k)为种子词, wtj(j=1, 2, …, k)为sj对应的情感权重。S表示具有明显情感极性的情感词集合, 如“干净”“安静”“很好”等为正向情感种子词, “混乱”“嘈杂”“恶劣”等为负向情感种子词。由于同一词汇在不同领域语料中的表达存在语义不一致的情况, 如“垃圾”在评论文中, 作为形容词可用于表达“极差”的意义, 作为名词可用于表达“废弃物品”。因此, 在选择种子词时, 不考虑词性的影响, 直接以TF-IDF值作为参考。对于领域语料得到词集C, 通过设定TF-IDF的阈值, 筛选得到候选词集CL={(c1, tf-idf1), (c2, tf-idf2), …, (cn, tf-idfn)}(n≤m), CL表示情感特征未知的词汇。设置word2vec的模型参数, 将数据集Data_w2v作为训练集, 输入到word2vec进行训练, 保存word2vec模型为M_w2v。该算法主要原理是通过计算词集CL中每一个词ci与S中各个词的相似度来实现ci的情感分布。如“卫生”与种子词集{“干净”“安静”“很好”, …, “混乱”“嘈杂”“恶劣”, …}中各个词汇的相似度{0.86, 0.43, 0.40, …, 0.02, 0.11, 0.06, …}, 表示“卫生”在这些情感表达上的权重, 实现对ci情感表达的抽象表示, 达到能更好地实现情感计算的效果。

|

图 2 领域情感词典构建过程 Figure 2 Process of building domain sentiment lexicon |

具体方法是通过相似度similarity函数fs, 分别计算情感词ci(i=1, 2, …, m)与种子词集S中各个种子词的相似度, 得到相似度向量Sim=[Simi1 Simi2 … Simij … Simik]; 进而将Sim与[wt1 wt2 … wtk]进行点乘计算, 再与词ci的TF-IDF值tf-idfi乘积, 得到词ci的情感特征向量分布ei; 最终获得情感向量特征集合Senti2vec=[(c1, e11×k) (c2, e21×k) … (cn, en1×k)]。

图 2中, 利用word2vec的语义相似度, 将候选情感词c映射到高维向量表示, 实现了情感词在语义空间和情感空间上的映射。具体的算法如下所示:

算法 领域情感词典构建算法

输入 word2vec模型参数{向量维数(-size), 上下文窗口大(-window), 高频词采样的阈值(-sample), cbow/skip-gram (-isCbow)}, word2vec训练数据集Data_w2v, 酒店评论语料数据集Data_domain种子词集S, 情感本体SO

输出 Senti2vec

步骤1 初始化word2vec模型:-size=200, -window=5, -sample=0.001, -isCbow=true; C=Ø; CL=Ø; Senti2vec=Ø;

步骤2 将Data_w2v进行分词、去标点符号等预处理之后, 输入模型, 训练得到word2vec模型M_w2v;

步骤3 将Data_domain进行分词和计算词汇的TF-IDF值, 得到词集C={(c1, tf-idf1), (c2, tf-idf2), …, (cm, tf-idfm)};

步骤4 根据TF-IDF值对C按从大到小顺序排序, 对排序后的每一个(ci, tf-idfi) ((ci, tf-idfi)∈C):如果ci∈SO, 同时ci在SO中的情感强度wti≥7, 则ci→si, (si, wti)→S;

步骤5 对每一个(ci, tf-idfi) ((ci, tf-idfi)∈C):如果tf-idfi≥a(a∈[0, 1]), 则(ci, tf-idfi)→CL; 得到CL={(c1, tf-idf1), (c2, tf-idf2), …, (cn, tf-idfn)}(n≤m);

步骤6 对每一个(ci, tf-idfi) ((ci, tf-idfi)∈CL):在M_w2v中获得的ci词向量vci; 对每一个sj (sj∈S):在M_w2v中获得的sj词向量vsj; 计算vci和vsj的余弦相似度

| $ \begin{array}{l} {\rm{Si}}{{\rm{m}}_{ij}}\left( {{\rm{Si}}{{\rm{m}}_{ij}} \in {\rm{Sim}}} \right) \leftarrow {f_s}\left( {{c_i}, {s_j}} \right) = \\ \;\;\;\;\;\;\left( {{v_{ci}} \cdot {v_{sj}}} \right)/\left( {\left| {{v_{ci}}} \right| + \left| {{v_{sj}}} \right|} \right)。\end{array} $ | (1) |

步骤7 将Sim与种子词情感权重向量[wt1 wt2 … wtk]进行点乘计算, 得到词语的情感特征向量

| $ \mathit{\boldsymbol{e}}_i^{1 \times k} \leftarrow {\bf{Sim}} \cdot \left[ {{\rm{w}}{{\rm{t}}_{\rm{1}}}\;{\rm{w}}{{\rm{t}}_{\rm{2}}} \cdots \;{\rm{w}}{{\rm{t}}_k}} \right] \times {\rm{tf}} - {\rm{id}}{{\rm{f}}_i}。$ | (2) |

步骤8 输出Senti2vec={(c1, e11×k), …, (cm, em1×k)}。

模型的输出Senti2vec, 融合了word2vec模型的语义和种子词的情感两个层面, 实现了情感词的高维向量空间映射。同时, 该算法应用于词汇的情感特征向量生成, 不受不同领域词汇差异性的约束。

2 试验结果及分析 2.1 试验设计情感特征向量通过将情感映射到高维空间, 对情感表达的有效性, 主要体现在情感和语义相近的词汇, 其空间距离小。如“漂亮-美丽”“开心-快乐”等情感近似词组具有较强的情感和语义相似性, 其空间距离应该小, 相似度应该高, 因此可用于识别情感相关词组。通过情感特征向量, 能准确获得情感词的极性(“正向”或“负向”), 表明情感特征向量是区分词语情感的有效验证方法。因此, 将所得的情感特征向量应用到如表 1所示试验, 以验证构建的领域情感词典的有效性。目前尚未发现公开的权威领域词典可作为试验对比, 因此, 在任务2中酒店评论分类中, 主要对比了相关情感词典的构建方法和本研究提出方法的表现。

| 表 1 情感特征向量验证试验 Table 1 Confirmatory experiments of sentimental feature vector |

对以上任务的评价, 选用总体准确率作为评价性能指标:acc=cor/all, acc∈[0, 1.0], 其中acc为总体准确率, cor为分析正确的数量, all为全部分析对象的数量。

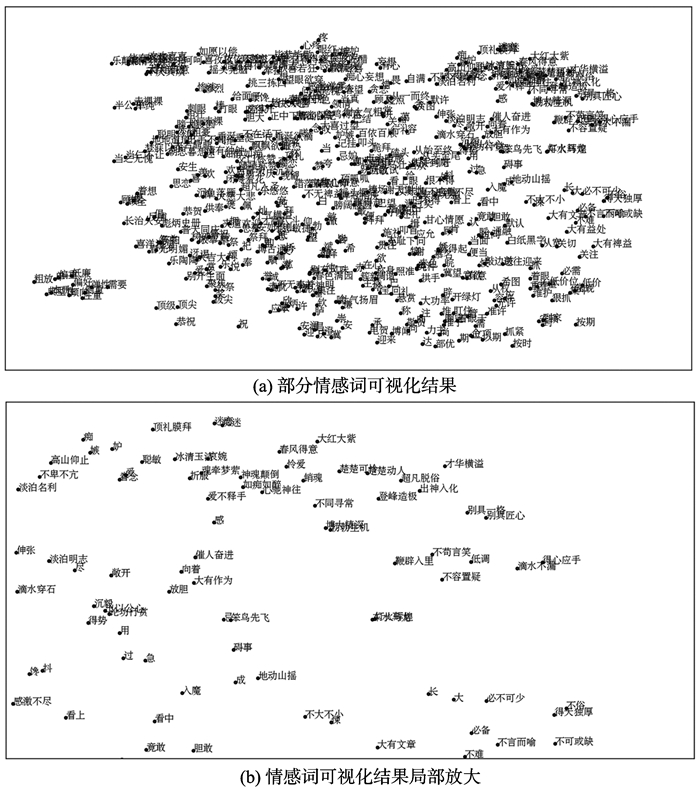

2.2 领域情感词典构建结果对采集的10万条和ChnSentiCorp-Htl-del-4000酒店评论数据进行处理, 去掉停用词汇, 设置TF-IDF值的阈值a=0.4, 获得候选词汇9 860个。利用提出的领域情感词典构建算法, 获得情感特征向量Senti2vec, 情感特征向量与种子词集的词汇量一致, 即将每个情感词映射到80维的向量空间, 采用基于python的数据可视化工具t-sen[22]进行可视化, 如图 3所示, 距离越近表示语义和情感越相似。

|

图 3 基于t-sen领域情感词典可视化 Figure 3 Visualization of domain sentiment lexicon based on t-sen |

为更好的观察情感词的相似性, 图 3(b)为图 3(a)中的局部放大显示, 可见如“匠心独具”“别具匠心”“独具一格”“妙趣”等情感词在语义和情感上都有一定的相似性, 在情感向量空间上相对应的距离也比较近, 说明了情感特征向量对语义和情感聚合效果比较好。

基于word2vec模型输出的200维词向量和Senti2vec的80维情感特征向量, 利用similarity函数, 获取情感词最相似的5个词汇, 结果如表 2所示。

| 表 2 相似词及相似度示例(top 5) Table 2 Examples of similar words and similarity (top 5) |

表 2为情感词“悲哀”“漂亮”和“不错”的排名前5的相似词汇及其对应的相似度。由表 2可知, word2vec和Senti2vec在语义上都有较好的表现, 能获得情感和语义均比较相似的词汇, 但Senti2vec词汇的相似性更强; 另外, 以词汇“不错”为例, 利用word2vec获得最相似词为“不好”, 在语义和情感上均是距离比较大的, 而利用Senti2vec在语义和情感上均有一致性的表现。从数据量角度分析, Senti2vec将word2vec从200维的向量降到80维, 也是一种有效的降维方法。这些都说明了情感特征向量的优越性。

2.3 领域情感词典的验证试验及结果分析(1) 情感词极性分类试验

情感词的极性判断和权重计量, 是情感词典构建的核心研究。柳位平等[6]提出了基于HowNet和SO-IR算法的情感词极性判断方法, 利用褒贬义种子词与HowNet中词语义原之间的相似度, 将正向义原的语义相似度平均值减去负向义原的平均值作为情感值, 大于零表示正向, 小于零表示负向, 绝对值为权重。阳爱民等[10]选用80个情感种子词, 利用搜索引擎返回的共现数, 通过改进的PMI算法计算情感词的情感权值。周咏梅等[7]通过新闻评论语料和基础情感词典获得评论情感词集和种子词, 基于PageRank算法的方法判定评论情感词集的极性并计算其强度, 提出基于HowNet和SentiWordNet的中文情感词典方法。文献[23]将词语自动分解为多个义原后计算其情感倾向强度, 并且使用词典校对方法对词语情感倾向强度进行优化。

为了验证情感特征的有效性, 本研究选取HowNet与CL的交集中2 000个情感词汇及其极性作为标准词集, 其中1 000个作为训练集, 1 000个作为测试集。对词语进行情感极性分类时, 情感词ci的word2vec向量表示为vci, 情感特征向量Senti2vec表示为ei。用于训练SVM分类器的情感词集合向量矩阵为v和e, 训练得到SVMw2c和SVMs2c两个分类器。将测试情感词集v和e分别作为SVMw2c和SVMs2c的输入, 对测试集进行二分类, 得到情感词极性的分类结果。同时, 对比了相关情感词极性判断研究, 试验结果如表 3所示。

| 表 3 情感词极性分类结果 Table 3 Results of polarity classification of sentiment words |

由表 3可知, Senti2vec+SVM方法可获得较高的准确率78.07%, 略低于SO-IR方法。两种都是基于语义相似的计算, HowNet是权威的知识库, 利用HowNet的相似度可获得良好的效果。但是HowNet受限于词典的规模, 比如网络用语“么么哒” “累觉不爱”等, 则无法利用HowNet方法进行相似度计算。Senti2vec方法是基于海量语料的知识统计获得的, 能有效获得这些网络用语的情感特征向量, 具有比基于HowNet更强的可拓展性。文献[10]基于搜索引擎的方法主要针对存在太多的垃圾网页信息, 检索回来的页面数量存在很多不相关因素, 导致准确率不高。文献[7]和文献[23]的方法, 在试验中的准确率略低于Senti2vec, 同时也容易受限于情感词典的规模。结果表明, 基于Senti2vec的方法在词汇拓展和情感极性判断均可获得更优的效果。

(2) 基于领域情感词典的酒店评论文本情感分类

将构建的领域情感词典应用于中文酒店评论语料情感分析试验。试验数据来源于谭松波老师的公开酒店评论语料数据, 共4 000条评论, 正负向语料各2 000条。抽取正负向评论语料各1 000条用于模型训练, 剩下数据用于测试。

采用支持向量机(SVM)构建文本情感分类器。SVM是一种监督式学习方法, 属于一般化线性分类器, 能够同时最小化经验误差与最大化几何边缘区, 因此SVM也称为最大边缘区分类器。

利用SVM进行分类时, 将评论文本分词、去停用词等预处理后, 选择CL中的词汇作为评论文本的情感特征, 每条评论可表示为doc={c1, c2, …, cn}, 词ci的word2vec向量表示为vci, 情感特征向量Senti2vec表示为ei。则评论的word2vec特征向量Vw2v=∑vci/n, 向量长度为200维; 评论的情感特征向量Senti2vec可表示为Vs2c=∑ei/n, 向量长度为80维。利用HowNet对评论文本进行向量表示时, 本研究基于传统的One-hot Representation, 评论的向量长度为情感词典的长度。评论文本的情感分类采用随机抽取正负向语料中的40%用于训练分类器, 60%用于分类试验。每项试验进行10次, 所有试验结果的平均值作为最终结果, 试验结果方差和结果如表 4所示。

| 表 4 文本情感分类结果 Table 4 Results of text sentiment classification |

由表 3可知, 采用Senti2vec+SVM可获得较好的分类准确率。总体的准确率偏低, 主要原因是只提取了酒店评论中的词汇作为特征, 没有考虑转折词、程度副词等对情感的影响。由于本研究主要是验证提取的情感特征向量的有效性, 因此仅提取其中情感词汇作为情感特征。对比基于情感词典[10]和基于机器学习[21-22]的酒店评论情感分类方法, Senti2vec将情感进行高维映射, 效果明显优于传统的二维或三维情感映射, 也说明了Senti2vec能更好地表示情感。同时比word2vec取得更好的效果, 说明Senti2vec能实现语义表示。试验结果表明, 提出的Senti2vec能更好地实现语义和情感的有效表示。

3 结语本研究主要利用词汇在领域语料中TF-IDF值的区分作用, 选择领域候选情感词集。针对领域情感词典中情感词的情感特征向量表示, 针对情感词的情感特征向量表示, 提出基于语义相似度的情感特征向量(Senti2vec)提取方法。这种方法融合了word2vec模型的语义优势和情感种子词集的情感表达优势, 将词汇映射到高维度向量空间, 实现了情感词在语义空间和向量空间的有效表示。同时, 基于词汇的TF-IDF值筛选, 构建的领域情感词典具有较好的领域表达性。通过试验和结果分析, 验证了提出方法的可行性和Senti2vec的有效性。在下一步研究工作中, 将进一步拓展训练数据集, 加入维基百科等语料, 训练具有更广域的语义表示, 进一步提升Senti2vec的领域可用性。

| [1] | XU G, MENG X F, WANG H F. Build Chinese emotion lexicons using a graph-based algorithm and multiple resources[C]//Proceedings of the 23rd international conference on computational linguistics. Beijing, China: ACM, 2010: 1209-1217. http://cpfd.cnki.com.cn/Article/CPFDTOTAL-ZGZR201008003063.htm |

| [2] | BACCIANELLA S, ESULI A, SEBASTIANI F. SentiWordNet 3. 0: an enhanced lexical resource for sentiment analysis and opinion mining[C]//Proceedings of International Conference on Language Resources and Evaluation, LREC 2010. Malta: LREC, 2010: 83-90. https://www.researchgate.net/publication/220746537_SentiWordNet_30_An_Enhanced_Lexical_Resource_for_Sentiment_Analysis_and_Opinion_Mining |

| [3] | DAI L L, XIA Y N, LIU B, et al. Measuring semantic similarity between words using HowNet[C]//Proceedings of the 2008 International Conference on Computer Science and Information Technology. Singapore: IEEE, 2008: 601-605. http://dl.acm.org/citation.cfm?id=1444597 |

| [4] | TABOADA M, BROOKE J, TOFILOSKI M, et al. Lexicon-based methods for sentiment analysis[J]. Computational linguistics, 2011, 37(2): 267-307 DOI:10.1162/COLI_a_00049 |

| [5] | DRAGUT E C, WANG H, SISTLA P, et al. Polarity consistency checking for domain independent sentiment dictionaries[J]. IEEE Transactions on Knowledge and Data Engineering, 2015, 27(3): 838-851 DOI:10.1109/TKDE.2014.2339855 |

| [6] | VO D T, ZHANG Y. Don't count, predict! an automatic approach to learning sentiment lexicons for short text[C]//Proceedings of the 54th annual meeting of the association for computational linguistics. Berlin, Germany: ACL, 2016: 219. https://www.researchgate.net/publication/306093429_Don't_Count_Predict_An_Automatic_Approach_to_Learning_Sentiment_Lexicons_for_Short_Text |

| [7] |

朱嫣岚, 闵锦, 周雅倩, 等. 基于hownet的词汇语义倾向计算[J].

中文信息学报, 2006, 20(1): 14-20 ZHU Yanlan, MIN Jin, ZHOU Yaqian, et al. Semantic orientation computing based on HowNet[J]. Journal of Chinese Information Processing, 2006, 20(1): 14-20 |

| [8] |

柳位平, 朱艳辉, 栗春亮, 等. 中文基础情感词词典构建方法研究[J].

计算机应用, 2009, 29(11): 2882-2884 LIU Weiping, ZHU Yanhui, LI Chunliang, et al. Research on building Chinese basic semantic lexicon[J]. Journal of Computer Applications, 2009, 29(11): 2882-2884 |

| [9] |

周咏梅, 阳爱民, 杨佳能. 一种新闻评论情感词典的构建方法[J].

计算机科学, 2014, 41(08): 67-69 ZHOU Yongmei, YANG Aimin, YANG Jianeng. Construction method of sentiment lexicon for news reviews[J]. Computer Science, 2014, 41(08): 67-69 |

| [10] | YANG Aimin, LIN Jianghao, ZHOU Yongmei, et al. Research on building a Chinese sentiment lexicon based on SO-PMI[J]. Applied Mechanics and Materials, 2013, 263-266((1): 1688-1693 |

| [11] |

周咏梅, 阳爱民, 林江豪. 中文微博情感词典构建方法[J].

山东大学学报(工学版), 2014, 44(3): 36-40 ZHOU Yongmei, YANG Aimin, LIN Jianghao. A method of building Chinese microblog sentiment lexicon[J]. Journal of Shandong University (Engineering Science), 2014, 44(3): 36-40 DOI:10.6040/j.issn.1672-3961.1.2013.103 |

| [12] | WANG G, ARAKI K. Modifying SO-PMI for Japanese weblog opinion mining by using a balancing factor and detecting neutral expressions[C]//Proceedings of Human Language Technology Conference of the North American Chapter of the Association of Computational Linguistics. New York, America: ACL, 2007: 189-192. http://dl.acm.org/citation.cfm?id=1614156 |

| [13] |

彭丽针, 吴扬扬. 基于维基百科社区挖掘的词语语义相似度计算[J].

计算机科学, 2016, 43(4): 45-49 PENG Lizhen, WU Yangyang. Semantic similarity computing based on community mining of wikipedia[J]. Computer Science, 2016, 43(4): 45-49 |

| [14] |

陶富民, 高军, 王腾蛟, 等. 面向话题的新闻评论的情感特征选取[J].

中文信息学报, 2010, 24(3): 37-43 TAO Fumin, GAO Jun, WANG Tenjiao, et al. Topic oriented sentimental feature selection method for news comments[J]. Journal of Chinese Information Processing, 2010, 24(3): 37-43 |

| [15] |

李素科, 蒋严冰. 基于情感特征聚类的半监督情感分类[J].

计算机研究与发展, 2013, 50(12): 2570-2577 LI Suke, JIANG Yanbing. Semi-supervised sentiment classification based on sentiment feature clustering[J]. Journal of Computer Research and Development, 2013, 50(12): 2570-2577 DOI:10.7544/issn1000-1239.2013.20130878 |

| [16] |

贺飞艳, 何炎祥, 刘楠, 等. 面向微博短文本的细粒度情感特征抽取方法[J].

北京大学学报(自然科学版), 2014, 42(1): 48-54 HE Feiyan, HE Yanxiang, LIU Nan, et al. A microblog short text oriented multi-class feature extraction method of fine-grained sentiment analysis[J]. Acta Scientiarum Naturalium Universitatis Pekinensis, 2014, 42(1): 48-54 |

| [17] |

吴金源, 冀俊忠, 赵学武, 等. 基于特征选择技术的情感词权重计算[J].

北京工业大学学报, 2016, 42(1): 142-151 WU Jinyuan, JI Junzhong, ZHAO Xuewu, et al. Weight calculation of emotional word based on feature selection technique[J]. Journal of Beijing University of Technology, 2016, 42(1): 142-151 DOI:10.11936/bjutxb2015040085 |

| [18] | HAMOUDA A, MAREI M, ROHAIM M. Building machine learning based senti-word lexicon for sentiment analysis[J]. Journal of Advances in Information Technology, 2011, 2(4): 199-203 |

| [19] | PENNINGTON J, SOCHER R, MANNING C. Glove: global vectors for word representation[C]//Proceedings of the 2014 Conference on Empirical Methods in Natural Language Processing. Doha, Qatar: ACL, 2014: 1532-1543. https://www.researchgate.net/publication/284576917_Glove_Global_Vectors_for_Word_Representation |

| [20] | TSVETKOV Y, FARUQUI M, DYER C. Correlation-based intrinsic evaluation of word vector representations[C]//Proceedings of the Workshop on Evaluating Vector-Space Representations for Nlp. 2016. Berlin, Germany: ACL, 2016: 111-115. http://arxiv.org/abs/1606.06710 |

| [21] | CAMACHO-COLLADOS J, NAVIGLI R. Find the word that does not belong: A framework for an intrinsic evaluation of word vector representations[C]//Proceedings of the Workshop on Evaluating Vector-Space Representations for Nlp. 2016. Berlin, Germany: ACL, 2016: 43-50. https://www.researchgate.net/publication/306094134_Find_the_word_that_does_not_belong_A_Framework_for_an_Intrinsic_Evaluation_of_Word_Vector_Representations |

| [22] | LAURENS V D M. Accelerating t-SNE using tree-based algorithms[J]. Journal of Machine Learning Research, 2014, 15(1): 3221-3245 |

| [23] |

周咏梅, 杨佳能, 阳爱民. 面向文本情感分析的中文情感词典构建方法[J].

山东大学学报(工学版), 2013, 43(6): 27-33 ZHOU Yongmei, YANG Jianeng, YANG Aimin. A method on building Chinese sentiment lexicon for text sentiment analysis[J]. Journal of Shandong University (Engineering Science), 2013, 43(6): 27-33 |

| [24] |

杨鼎, 阳爱民. 一种基于情感词典和朴素贝叶斯的中文文本情感分类方法[J].

计算机应用研究, 2010, 27(10): 3737-3739, 3743 YANG Ding, YANG Aimin. Classification approach of Chinese texts sentiment based on semantic lexicon and naïve Bayesian[J]. Application Research of Computers, 2010, 27(10): 3737-3739, 3743 |