基于结构保持的流形学习算法, 将数据表示为嵌入高维空间的低维子流形, 其中确定数据的邻接图及权重矩阵是算法的关键。在无监督条件下,

低秩表示直接对系数矩阵进行整体约束, 能够揭示数据的全局结构信息, 又具有一定的聚类效果[8-10]。本研究使用低秩表示求解邻接图和权重矩阵, 提出低秩表示投影算法(low-rank representation projection, LRRP)。为了增强特征的鉴别能力, 引入低秩系数聚类后的类内距离约束项, 进一步提出鉴别低秩表示投影(discriminant low-rank representation projection, DLRRP)。在4个真实人脸数据库中进行比较试验, 结果说明本研究算法能有效提高人脸识别的正确率。

1 相关工作 1.1 线性保留投影假设训练样本矩阵

| $ {W_{ij}} = \left\{ {\begin{array}{*{20}{c}} {非零值 \in \left( {0,1} \right]}&{连接条件}\\ 0&{其他} \end{array}} \right., $ | (1) |

在经典LPP算法中, 连接条件一般是这样设置的:有监督情况下, 条件为

| $ \begin{array}{*{20}{c}} {\mathit{\boldsymbol{A}} = \mathop {\arg \min }\limits_\mathit{\boldsymbol{A}} \sum\limits_{ij}^m {{{\left( {{\mathit{\boldsymbol{x}}_i}{\mathit{\boldsymbol{A}}^{\rm{T}}} - {\mathit{\boldsymbol{x}}_j}{\mathit{\boldsymbol{A}}^{\rm{T}}}} \right)}^2}{W_{ij}}} = }\\ {\mathop {\arg \max }\limits_\mathit{\boldsymbol{A}} \frac{{{\mathit{\boldsymbol{A}}^{\rm{T}}}\mathit{\boldsymbol{XD}}{\mathit{\boldsymbol{X}}^{\rm{T}}}\mathit{\boldsymbol{A}}}}{{{\mathit{\boldsymbol{A}}^{\rm{T}}}\mathit{\boldsymbol{XL}}{\mathit{\boldsymbol{X}}^{\rm{T}}}\mathit{\boldsymbol{A}}}},} \end{array} $ | (2) |

式中:

| $ \mathit{\boldsymbol{XL}}{\mathit{\boldsymbol{X}}^{\rm{T}}}\mathit{\boldsymbol{A}} = \mathit{\boldsymbol{ \boldsymbol{\varLambda} XD}}{\mathit{\boldsymbol{X}}^{\rm{T}}}\mathit{\boldsymbol{A}}, $ | (3) |

投影矩阵

不同于式(1), 自适应的选取

| $ \begin{array}{l} {\mathit{\boldsymbol{\beta }}_i} = \mathop {\arg \min }\limits_{{\beta _i}} \left\| {{\mathit{\boldsymbol{X}}_i}{\mathit{\boldsymbol{\beta }}_i} - {\mathit{\boldsymbol{x}}_i}} \right\|_2^2 + \lambda {\left\| {{\mathit{\boldsymbol{\beta }}_i}} \right\|_1},\\ {\mathit{\boldsymbol{X}}_i} = \left[ {\begin{array}{*{20}{c}} {{x_1}}& \cdots &{{x_{i - 1}}}&0&{{x_{i + 1}}}& \cdots &{{x_m}} \end{array}} \right]。\end{array} $ | (4) |

在求第

| $ \begin{array}{*{20}{c}} {\mathit{\boldsymbol{A}} = \mathop {\arg \min }\limits_\mathit{\boldsymbol{A}} \sum\limits_{i = 1}^m {{{\left\| {{\mathit{\boldsymbol{A}}^{\rm{T}}}{\mathit{\boldsymbol{x}}_i} - {\mathit{\boldsymbol{A}}^{\rm{T}}}\mathit{\boldsymbol{X}}{\mathit{\boldsymbol{\beta }}_i}} \right\|}^2}} = }\\ {\mathop {\arg \min }\limits_\mathit{\boldsymbol{A}} {\mathit{\boldsymbol{A}}^{\rm{T}}}\mathit{\boldsymbol{X}}\left( {\mathit{\boldsymbol{I}} - \mathit{\boldsymbol{S}}} \right){{\left( {\mathit{\boldsymbol{I}} - \mathit{\boldsymbol{S}}} \right)}^{\rm{T}}}{\mathit{\boldsymbol{X}}^{\rm{T}}}\mathit{\boldsymbol{A}} = }\\ {\mathop {\arg \max }\limits_\mathit{\boldsymbol{A}} {\mathit{\boldsymbol{A}}^{\rm{T}}}\mathit{\boldsymbol{X}}{\mathit{\boldsymbol{L}}_S}{\mathit{\boldsymbol{X}}^{\rm{T}}}A,} \end{array} $ | (5) |

式中:

| $ \mathit{\boldsymbol{X}}{\mathit{\boldsymbol{L}}_S}{\mathit{\boldsymbol{X}}^{\rm{T}}}\mathit{\boldsymbol{A}} = \mathit{\boldsymbol{ \boldsymbol{\varLambda} X}}{\mathit{\boldsymbol{X}}^{\rm{T}}}\mathit{\boldsymbol{A}}。$ | (6) |

CRP与SPP的思想相同, 也是利用正则化的线性回归形式求出训练样本之间的相似关系, 不同的是, CRP使用

| $ \begin{array}{*{20}{c}} {{\mathit{\boldsymbol{\beta }}_i} = \mathop {\arg \min }\limits_{{\mathit{\boldsymbol{\beta }}_i}} \left\| {{\mathit{\boldsymbol{X}}_i}{\mathit{\boldsymbol{\beta }}_i} - {\mathit{\boldsymbol{x}}_i}} \right\|_2^2 + \lambda {{\left\| {{\mathit{\boldsymbol{\beta }}_i}} \right\|}_2},}\\ {{\mathit{\boldsymbol{X}}_i} = \left[ {\begin{array}{*{20}{c}} {{x_1}}& \cdots &{{x_{i - 1}}}&0&{{x_{i + 1}}}& \cdots &{{x_m}} \end{array}} \right]。} \end{array} $ | (7) |

使用总体散度矩阵(

| $ \mathit{\boldsymbol{X}}{\mathit{\boldsymbol{L}}_c}{\mathit{\boldsymbol{X}}^{\rm{T}}}\mathit{\boldsymbol{A}} = \mathit{\boldsymbol{ \boldsymbol{\varLambda} }}\left( {\mathit{\boldsymbol{X}} - \mathit{\boldsymbol{\bar X}}} \right){\left( {\mathit{\boldsymbol{X}} - \mathit{\boldsymbol{\bar X}}} \right)^{\rm{T}}}\mathit{\boldsymbol{A}}, $ | (8) |

式中:

低秩表示(LRR)可以有效地保留数据类别之间的差异性, 将其运用到图像聚类上, 可取得良好的效果[12], 其数学模型为

| $ \begin{array}{l} \min \;{\rm{rank}}\left( \mathit{\boldsymbol{Z}} \right)\\ {\rm{s}}.{\rm{t}}.\;\mathit{\boldsymbol{X}} = \mathit{\boldsymbol{XZ}} + \mathit{\boldsymbol{\eta E}}, \end{array} $ | (9) |

式中:

由于上述优化问题为NP-hard问题, 可以使用核范数替代秩数, 将其转化为凸优化问题:

| $ \begin{array}{l} \min \;\;{\left\| \mathit{\boldsymbol{Z}} \right\|_ * } + \lambda {\left\| \mathit{\boldsymbol{E}} \right\|_{2,1}}\\ {\rm{s}}.{\rm{t}}.\;\mathit{\boldsymbol{X}} = \mathit{\boldsymbol{XZ}} + \mathit{\boldsymbol{E}}。\end{array} $ | (10) |

为了利用LRR较强的全局信息提取能力和系数具有聚类效果的特点, 将其应用到局部保留算法中, 可以得到鲁棒性更强的自适应局部保留算法。首先对训练样本

| $ \begin{array}{*{20}{c}} {\mathop {\min }\limits_\mathit{\boldsymbol{W}} \;\;{{\left\| \mathit{\boldsymbol{W}} \right\|}_ * } + \lambda {{\left\| \mathit{\boldsymbol{E}} \right\|}_{2,1}}}\\ {{\rm{s}}.{\rm{t}}.\;\mathit{\boldsymbol{X}} = \mathit{\boldsymbol{XW}} + \mathit{\boldsymbol{E}},} \end{array} $ | (11) |

式中:

| $ \begin{array}{l} \mathop {\min }\limits_\mathit{\boldsymbol{A}} \sum\limits_i^m {{{\left( {{\mathit{\boldsymbol{A}}^{\rm{T}}}{\mathit{\boldsymbol{x}}_i} - {\mathit{\boldsymbol{A}}^{\rm{T}}}\mathit{\boldsymbol{X}}{\mathit{\boldsymbol{w}}_i}} \right)}^2}} = \\ \;\;\;\;\;\;\;\;\;\;\;\mathop {\min }\limits_\mathit{\boldsymbol{A}} \sum\limits_i^m {{\mathit{\boldsymbol{A}}^{\rm{T}}}\left( {{\mathit{\boldsymbol{x}}_i} - \mathit{\boldsymbol{X}}{\mathit{\boldsymbol{w}}_i}} \right){{\left( {{\mathit{\boldsymbol{x}}_i} - \mathit{\boldsymbol{X}}{\mathit{\boldsymbol{w}}_i}} \right)}^{\rm{T}}}\mathit{\boldsymbol{A}}} = \\ \;\;\;\;\;\;\;\;\;\;\;\mathop {\min }\limits_\mathit{\boldsymbol{A}} {\mathit{\boldsymbol{A}}^{\rm{T}}}\mathit{\boldsymbol{X}}\left( {\mathit{\boldsymbol{I}} - \mathit{\boldsymbol{W}}} \right){\left( {\mathit{\boldsymbol{I}} - \mathit{\boldsymbol{W}}} \right)^{\rm{T}}}{\mathit{\boldsymbol{X}}^{\rm{T}}}\mathit{\boldsymbol{A}} = \\ \;\;\;\;\;\;\;\;\;\;\;\mathop {\max }\limits_\mathit{\boldsymbol{A}} {\mathit{\boldsymbol{A}}^{\rm{T}}}\mathit{\boldsymbol{X}}{\mathit{\boldsymbol{L}}_\mathit{\boldsymbol{L}}}{\mathit{\boldsymbol{X}}^{\rm{T}}}A, \end{array} $ | (12) |

使用

| $ \mathit{\boldsymbol{X}}{\mathit{\boldsymbol{L}}_\mathit{\boldsymbol{L}}}{\mathit{\boldsymbol{X}}^{\rm{T}}}\mathit{\boldsymbol{A}} = \mathit{\boldsymbol{ \boldsymbol{\varLambda} X}}{\mathit{\boldsymbol{X}}^{\rm{T}}}\mathit{\boldsymbol{A}}, $ | (13) |

式中:

相比

| $ \begin{array}{l} \min \sum\limits_k^C {\sum\limits_l^{{n_k}} {{{\left( {{\mathit{\boldsymbol{A}}^{\rm{T}}}{\mathit{\boldsymbol{x}}_l} - {\mathit{\boldsymbol{A}}^{\rm{T}}}{{\mathit{\boldsymbol{\bar x}}}_k}} \right)}^2}} } = \\ \;\;\;\;\;\;\min {\mathit{\boldsymbol{A}}^{\rm{T}}}\left( {\mathit{\boldsymbol{X}}{\mathit{\boldsymbol{X}}^{\rm{T}}} - \sum\limits_k^C {{n_k}{{\mathit{\boldsymbol{\bar x}}}_k}\mathit{\boldsymbol{\bar x}}_k^{\rm{T}}} } \right)\mathit{\boldsymbol{A}} = \\ \;\;\;\;\;\;\min {\mathit{\boldsymbol{A}}^{\rm{T}}}\left( {\mathit{\boldsymbol{X}}{\mathit{\boldsymbol{X}}^{\rm{T}}} + \mathit{\boldsymbol{XH}}{\mathit{\boldsymbol{X}}^{\rm{T}}}} \right)\mathit{\boldsymbol{A}} = \\ \;\;\;\;\;\;\min {\mathit{\boldsymbol{A}}^{\rm{T}}}\mathit{\boldsymbol{X}}{\mathit{\boldsymbol{L}}_1}{\mathit{\boldsymbol{X}}^{\rm{T}}}A, \end{array} $ | (14) |

式中:

| $ \begin{array}{*{20}{c}} {\mathop {\min }\limits_\mathit{\boldsymbol{A}} {\mathit{\boldsymbol{A}}^{\rm{T}}}\mathit{\boldsymbol{X}}\left( {\mathit{\boldsymbol{I}} - \mathit{\boldsymbol{S}}} \right){{\left( {\mathit{\boldsymbol{I}} - \mathit{\boldsymbol{S}}} \right)}^{\rm{T}}}{\mathit{\boldsymbol{X}}^{\rm{T}}}\mathit{\boldsymbol{A}} + \gamma {\mathit{\boldsymbol{A}}^{\rm{T}}}\mathit{\boldsymbol{X}}{\mathit{\boldsymbol{L}}_1}{\mathit{\boldsymbol{X}}^{\rm{T}}}\mathit{\boldsymbol{A}} = }\\ {\mathop {\min }\limits_\mathit{\boldsymbol{A}} {\mathit{\boldsymbol{A}}^{\rm{T}}}\mathit{\boldsymbol{X}}\left[ {\left( {\mathit{\boldsymbol{I}} - \mathit{\boldsymbol{S}}} \right){{\left( {\mathit{\boldsymbol{I}} - \mathit{\boldsymbol{S}}} \right)}^{\rm{T}}} + \gamma {\mathit{\boldsymbol{L}}_1}} \right]{\mathit{\boldsymbol{X}}^{\rm{T}}}\mathit{\boldsymbol{A}},} \end{array} $ | (15) |

式中:

| $ \mathit{\boldsymbol{X}}\left( {2\mathit{\boldsymbol{S}} + \mathit{\boldsymbol{S}}{\mathit{\boldsymbol{S}}^{\rm{T}}} - \gamma {\mathit{\boldsymbol{L}}_1}} \right){\mathit{\boldsymbol{X}}^{\rm{T}}}\mathit{\boldsymbol{A}} = \mathit{\boldsymbol{ \boldsymbol{\varLambda} X}}{\mathit{\boldsymbol{X}}^{\rm{T}}}\mathit{\boldsymbol{A}}, $ | (16) |

将特征向量按照特征值从大到小的顺序排列可得到投影矩阵

将LRRP、DLRRP在AR[15]、Extend YaleB(简记为YaleB)[16]、FERET和CMU-PIE这4个真实人脸数据库中进行人脸识别[17-18], 并与PCA、LDA、LPP、SPP、CRP方法进行比较。其中利用表示算法求权重矩阵的LPP、SPP、CRP及本研究算法中的系数正则化参数

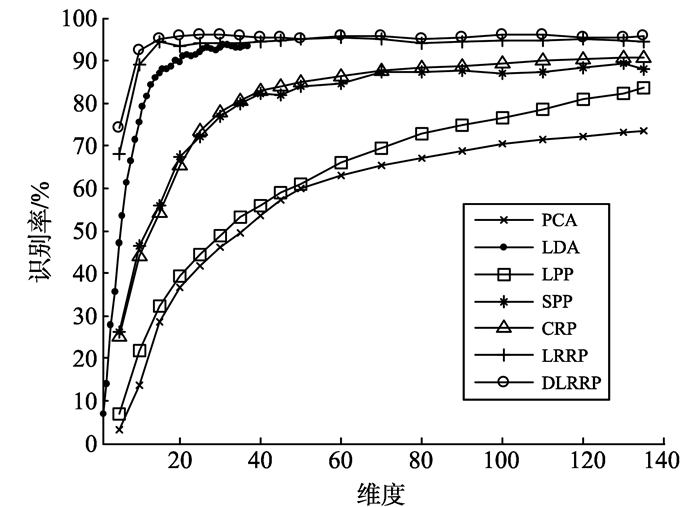

由于SPP运算量较大, 为了方便试验对比, 本研究只使用AR人脸数据库中的前100个对象进行试验, 每个对象26张人脸图像, 第一阶段的13张作为训练样本, 第二阶段的13张作为测试样本, 在每一阶段中, 前4张反应姿态变化, 5~7张处于不同光照, 8~13张存在面部遮挡。最高识别率及其对应的维度记录在表 1中, 不同维度对应的识别率展示在图 1中。

| 表 1 在AR人脸库上各方法的最高识别率 Table 1 The top-one recognition accuracies of the methods on AR face database |

|

图 1 AR人脸库中维度对识别率的影响 Figure 1 The influence of dimensions on recognitionaccuracies on AR database |

由表 1和图 1可知, LRRP的识别率比SPP和CRP高。而加入判别信息之后, 相比于LRRP, DLRRP的识别率有很大提高, 达到了78.38%, 稍高于LDA的76.67%, 说明低秩系数确实有助于提供图像的聚类信息, 构造的判别项即使在无标签信息情况下也会接近甚至优于有监督算法的LDA的识别率, 但DLRRP的最优识别率对应的维度大于LDA。需要说明的是, 在此试验中LRRP的识别率低于LDA, 这是因为LDA作为有监督的特征提取方法, 在训练样本比较充足的情况下要优于无监督算法。但是在图 1和表 1中可以看到, 在无监督条件下的算法中, LRRP的识别率高于SPP和CRP的。

研究低秩表示正则化参数

|

图 2 正则化参数 |

采用类似方法, 在[0, 1]寻找最优平衡参数

|

图 3 DLRRP中 |

Extended Yale B人脸数据库包含38个对象, 每个对象64张图片, 将其剪切为40×40大小。随机选取其中的32张图片作为训练样本, 剩余的32张图片作为测试样本, 测试20次, 取平均值, 每种方法对应的最高识别率如表 2所示。

| 表 2 各方法在YaleB人脸库上的最优识别率 Table 2 The top-one recognition accuracies of the methods onYaleB face database |

从表 2可以看出, LRRP的识别率要高于SPP和CRP, 这种优势是源于LRR对于噪声的强鲁棒性和良好的全局信息提取能力, 由于缺乏监督信息, 在相同的维度下识别率略低于LDA。DLRRP引入类内距离最小化项, 利用系数的聚类信息, 相比于LRRP, 其识别率有较大提高, 略高于LDA。

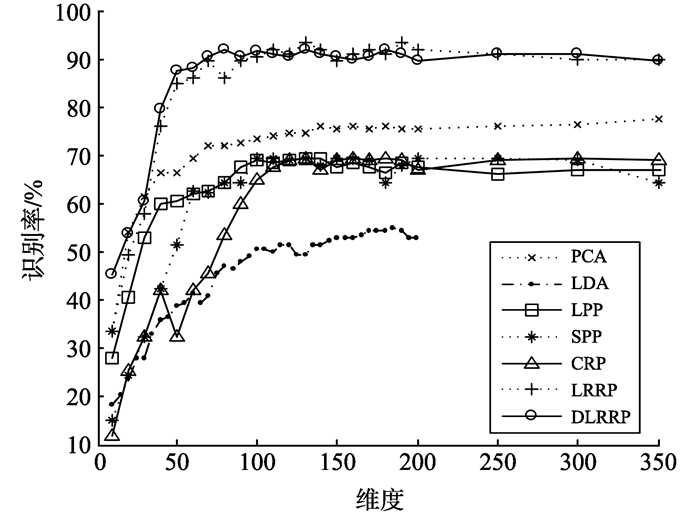

图 4展示各方法在Extended YaleB人脸数据库上, 维度对识别率的影响。

|

图 4 YaleB人脸库中维度对识别率的影响 Figure 4 The influence of dimensions on recognitionaccuracies on YaleB database |

从图 4中可以看到低维度时LRRP的识别率远高于SPP和CRP。由于引入类内距离约束项, DLRRP的鉴别能力很强, 在维度很低时就能达到比较高的识别率, 略高于LDA和LRRP。

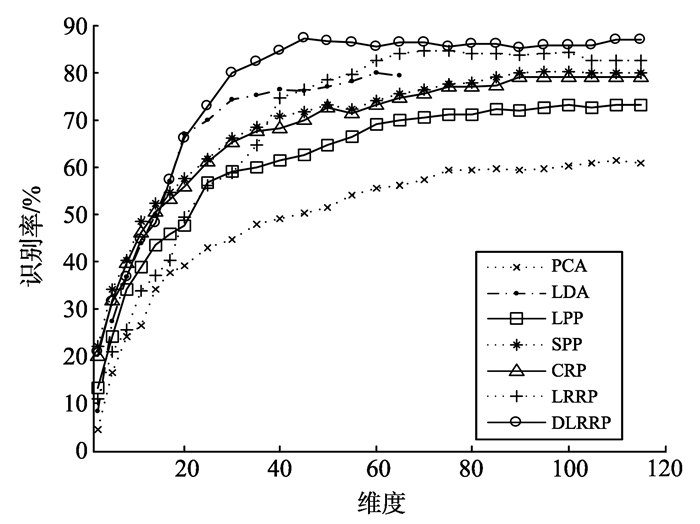

3.3 FERET人脸数据库FERET人脸数据, 共200个对象, 每个对象7张人脸图片, 每张图片的大小为40×40, 取前6张人脸图片作为训练样本, 剩余的1张作为测试样本。各个算法的最高识别率记录在表 3中, 维度对于识别率的影响展示在图 5中。

| 表 3 各方法在FERET人脸库上的最优识别率 Table 3 The top-one recognition accuracies of the methods onFERET face database |

|

图 5 FERET人脸库中维度对识别率的影响 Figure 5 The influence of dimensions on recognitionaccuracies on FERET database |

从表 3和图 5中可以看出, LRRP的识别率最高, 略高于DLRRP, 比SPP和CRP高12%, 且远远高于PCA、LPP和LDA。DLRRP的鉴别能力低于LRRP是由于类内约束项在小样本情况下的不佳表现导致, 这种情况和LDA在小样本情况下存在的问题相似。在这个数据库中, 从LDA算法的结果看出, 由于人脸图像角度的变化是图像之间的最大差异, 即使在有监督的情况下, LDA也对角度变化的鲁棒性差。

3.4 CMU-PIE人脸数据库CMU-PIE人脸数据库包含68个对象, 每个对象包括24张不同光照强度的人脸图像, 将其剪切为32×32大小。每类中随机选取8张人脸图片作为训练样本, 其余的16张人脸图像作为测试样本。表 4记录了各个算法的最高识别率。

| 表 4 各方法在CMU-PIE人脸库上的最优识别率 Table 4 The top-one recognition accuracies of the methods onCMU-PIE face database |

由表 4可以看到, DLRRP在最小降维维度就达到最优识别率, 且最优识别率比LRRP高3.78%, 进一步说明DLRRP的鉴别能力要优于LRRP。图 6展示各方法在CMU-PIE人脸数据库上, 特征维度对识别率的影响。由图 6可以看出, DLRRP识别率关于维度的快速收敛性。

|

图 6 CMU-PIE库中维度对识别率的影响 Figure 6 The influence of dimensions on recognitionaccuracies on CMU-PIE database |

本研究利用低秩表示自适应地获得数据点的最近邻及权重矩阵, 提出LRRP和DLRRP算法进行人脸图像的特征提取。不同于稀疏表示和协同表示, 低秩表示系数包含全局结构信息, 对于噪声有很强的鲁棒性。将全部训练样本进行自身的低秩表示, 并将此种低秩表示关系保留在特征空间中, 建立LRRP目标函数。另一方面, 考虑低秩系数所反应的样本的聚类关系, 引入类内距离约束项, 进一步提出更加具有鉴别性的DLRRP。在AR、Extended Yale B、FERET和CMU-PIE人脸数据库中的试验表明, 低秩表示本身具有的聚类效果导致LRRP的鲁棒性更强, 鉴别能力相比于SPP和CRP也有提高; 由低秩表示所计算的最小化类内距离约束项确实有效增强DLRRP的鉴别能力。

本研究算法是线性方法, 通过核技术的引入可扩展为非线性特征提取算法; 另外在加入鉴别项时假设已知类别数目, 下一步将研究未知类别数目下的聚类算法在鉴别信息计算中的应用。

(下转第 30 页)

| [1] | ROWEIS S T, SAUL L K. Nonlinear dimensionality reduction by locally linear embedding[J]. Science, 2000, 290: 2323-2326 DOI:10.1126/science.290.5500.2323 |

| [2] | BELKIN M, NIYOGI P. Laplacian eigenmaps and spectral techniques for embedding and clustering[C]//Proceedings of International Conference on Neural Information Processing Systems: Natural and Synthetic. Vancouver, Canada: MIT Press, 2001: 585-591. |

| [3] | HE Xiaofei, NIYOGI P. Locality preserving projections[C]//Proceedings of the Seventeenth Annual Conference on Neural Information Processing Systems. Massachusetts, USA:MIT Press, 2003. |

| [4] |

黄璞, 唐振民. 无参数局部保持投影及人脸识别[J].

模式识别与人工智能, 2013, 26(9): 865-871 HUANG Pu, TANG Zhenmin. Parameter-free locality preserving projections and face recognition[J]. Pattern Recognition and Artificial Intelligence, 2013, 26(9): 865-871 |

| [5] | QIAO Lishan, CHEN Songcan, TAN Xiaoyang. Sparsity preserving projections with applications to face recognition[J]. Pattern Recognition, 2010, 43(1): 331-341 |

| [6] | ZHANG Lei, YANG Meng, FENG Xiangchu. Sparse representation or collaborative representation: which helps face recognition?[C]//Proceedings of 2011 International Conference on Computer Vision. Barcelona, Spain: IEEE, 2011:471-478. |

| [7] | YANG Wankou, WANG Zhenyu, SUN Changyin. A collaborative representation based projections method for feature extraction[J]. Pattern Recognition, 2015, 48: 20-27 DOI:10.1016/j.patcog.2014.07.009 |

| [8] |

杨国亮, 谢乃俊, 罗璐, 等. 基于空间约束低秩图的人脸识别[J].

计算机科学, 2014, 41(8): 297-300 YANG Guoliang, XIE Naijun, LUO Lu, et al. Low-rank graph with spatial constraint for face recognition[J]. Computer Science, 2014, 41(8): 297-300 DOI:10.11896/j.issn.1002-137X.2014.08.063 |

| [9] | LIU Guangcan, LIN Zhouchen, YU Yong. Robust subspace segmentation by low-rank representation[C]//Proceedings of International Conference on Machine Learning. Haifa, Israel: Omnipress, 2010:663-670. |

| [10] | WRIGHT J, WRIGHT J, GANESH A, et al. Robust principal component analysis: exact recovery of corrupted low-rank matrices by convex optimization[C]// Proceedings of International Conference on Neural Information Processing Systems. Vancouver, Canada: Curran Associates Inc., 2009:2080-2088. |

| [11] | HE Xiaofei, MA Weiying, ZHANG Hongjiang. Learning an image manifold for retrieval[C]//Proceedings of ACM International Conference on Multimedia. New York, USA:ACM, 2004:17-23. |

| [12] | LIU Guangcan, LIN Zhouchen, YAN Shuicheng, et al. Robust recovery of subspace structures by low-rank representation[J]. IEEE Transaction on Pattern and Machine Recognition, 2013, 35(1): 171-184 DOI:10.1109/TPAMI.2012.88 |

| [13] | GAN Guojun, NG K P. Subspace clustering using affinity propagation[J]. Pattern Recognition, 2015, 48(4): 1455-1464 DOI:10.1016/j.patcog.2014.11.003 |

| [14] | BOYD S, VANDERBERGHE L. Convex optimization[M]. New York, USA: Cambridge University Press, 2007: 75-78. |

| [15] | MARTINEZ A, BENAVENTE R. The AR face database[R]. USA, Purdue University West Lafayette:Computer Vision Center: Technical Report, 1998. |

| [16] | GEORGHIADES A S, BELHUMEUR P N, KRIEGMAN D J. From few to many: illumination cone models for face recognition under variable lighting and pose[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2001, 23(6): 643-660 DOI:10.1109/34.927464 |

| [17] | PHILLIPSP J, MOON H, RIZVI A, et al. The FERET valuation methodology for face recognition algorithms[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2000, 22(10): 1090-1104 DOI:10.1109/34.879790 |

| [18] | SIM T, BAKER S, BSAT M. The CMU pose, illumination, and expression database[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2003, 25(12): 1615-1618 DOI:10.1109/TPAMI.2003.1251154 |

| [19] | JOLLIFFE I T. Principal component analysis[M]. New York, USA: Springer-Verlag, 2002: 98-99. |

| [20] | ZHANG Limei, CHEN Songcan, QIAO Lishan. Graph optimization for dimensionality reduction with sparsity constraints[J]. Pattern Recognition, 2012, 45(3): 1205-1210 DOI:10.1016/j.patcog.2011.08.015 |